RunPod - AI云计算,快速扩展,无限可能

RunPod 的运作原理基于高度优化的云基础设施,结合强大的 GPU 资源,为用户提供无缝的 AI 工作负载处理。用户可以通过简单的界面快速创建和管理 GPU Pod,支持多种机器学习框架如 PyTorch 和 TensorFlow。以下是 RunPod 的工作流程:

-

创建 Pod: 用户可以选择所需的 GPU 类型和配置,快速创建一个新的 Pod。

-

选择模板: 提供多个预配置的模板,用户可以直接使用,或根据需要自定义模板。

-

快速部署: 通过 Flashboot 技术,Pod 的冷启动时间被压缩到毫秒级,确保用户能迅速开始工作。

-

自动扩展: 在无服务器模式下,RunPod 能根据实时需求自动调整 GPU 资源,确保高效的工作负载处理。

-

实时分析与监控: 提供实时使用分析和日志记录功能,帮助用户监控模型的运行状态和性能,进行必要的调优。

-

灵活计费: 用户按分钟计费,无需担心入站/出站费用,透明的成本控制使得预算管理更为简单。

要开始使用 RunPod,您只需按照以下步骤进行操作:

- 注册账户: 访问 RunPod 网站,点击注册并创建您的账户。

- 选择服务: 根据您的需求选择合适的 GPU 类型和服务计划。

- 创建 Pod: 通过简单的界面创建您的 GPU Pod,选择合适的模板。

- 部署模型: 将您的 AI 模型上传到 Pod,并开始训练或推理。

- 监控与管理: 利用实时分析工具监控您的 Pod 性能,进行必要的调整。

无论您是初创企业、学术机构还是大型企业,RunPod 都是您理想的 AI 云平台。通过无缝的 GPU 工作负载部署,快速的冷启动时间和灵活的计费方式,RunPod 将为您的机器学习项目提供强大的支持。马上开始,体验高性价比的 AI 云计算服务。

产品特性

RunPod 提供全球分布的 GPU 云服务,支持快速部署和灵活的工作负载处理.

通过 Flashboot 技术,实现冷启动时间低于 250 毫秒,快速响应用户需求.

支持无服务器架构,可根据实时需求自动扩展 GPU 资源,确保效率.

RunPod 按分钟计费,无入站/出站费用,提供透明的成本控制.

支持用户自定义容器,满足特定应用程序的需求,灵活配置环境.

提供高达 100TB 的 NVMe SSD 网络存储,确保数据访问快速可靠.

使用场景

在 RunPod 上进行大规模的 AI 模型训练,支持多种 GPU,快速完成训练任务。

为客户提供高效的实时推理服务,支持自动扩展以应对流量变化。

学术机构使用 RunPod 进行深度学习研究,快速迭代和实验。

初创企业利用 RunPod 快速构建和迭代 AI 产品,降低开发成本。

使用 RunPod 进行大数据处理和分析,支持长时间运行的计算任务。

在 RunPod 上部署容器化的机器学习应用,灵活配置环境。

常见问题

流量(2025-03)

月度流量

流量来源

热门关键词

| 关键词 | 流量 | 搜索量 | 点击成本 |

|---|---|---|---|

| runpod | 58740 | 75820 | 3.99 |

| runpod pricing | 3737 | 3580 | 3.40 |

| run pod | 2995 | 4480 | 8.57 |

| deepseek r1 | 2711 | 565970 | 0.95 |

| rent gpu | 1814 | 5400 | 3.90 |

地域分布

Whois

| 域名 | www.runpod.io |

替代产品

Helpedby AI

Outerspan

Blnk Finance

Okareo

HostedMCPPlatform

BackflipAI

AiNativeDeveloperToolsLandscape

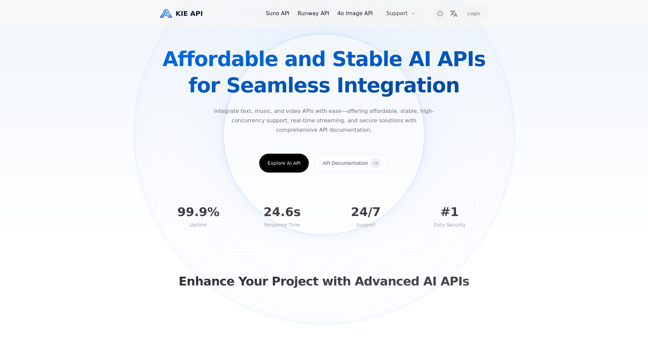

KieAI