Inferless - 即时部署ML模型

更新时间 2025-03-27

AI开发工具

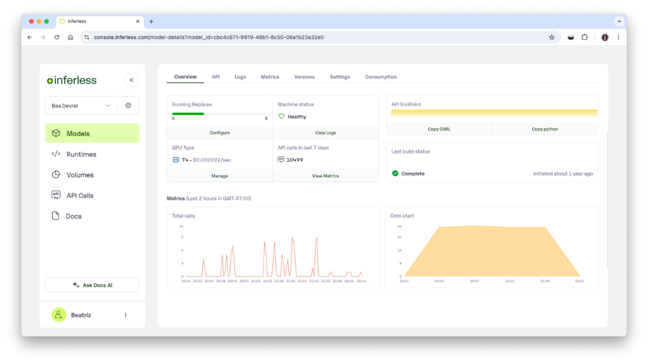

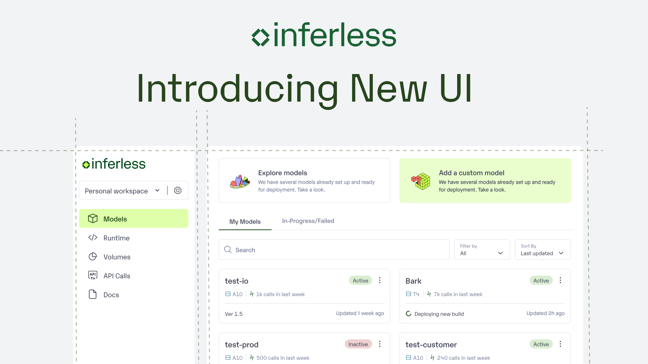

Inferless提供极速的无服务器GPU推理,轻松部署机器学习模型。无需基础设施管理,按需扩展,确保闪电般的冷启动。适用于AI驱动的组织,Inferless简化了从Hugging Face、Git、Docker或CLI的部署,具有自动重新部署和企业级安全性。

"在AI模型部署的世界里,时间就是金钱,而GPU资源就像黄金一样珍贵。Inferless的出现,让这一切变得前所未有的简单。"

🔥 为什么Inferless正在改变游戏规则

想象一下:你刚刚训练好了一个超棒的机器学习模型,迫不及待想把它部署上线。传统方式下,你需要:

- 配置服务器

- 管理GPU集群

- 处理负载均衡

- 担心冷启动问题

而Inferless把这些麻烦统统打包带走,让你从模型文件到部署端点,只需几分钟。

🚀 Inferless的核心优势

零基础设施管理

- 无需设置、管理或扩展GPU集群

- 即时部署模型,无需担心配置或维护

- 企业级SOC-2 Type II认证的安全保障

按需扩展,按使用付费

- 自动根据工作负载扩展

- 从1个请求到数百万请求都能应对

- 没有闲置成本,只有纯粹的效率

闪电般的冷启动

- 优化后的即时模型加载

- 即使是大模型也能实现亚秒级响应

- 无需预热等待

💡 真实用户怎么说?

"Inferless帮助我们保持低固定成本,有效扩展,不再担心高负载时的冷启动问题。我们在GPU云账单上节省了近90%,并且在不到一天的时间内就上线了。" —— Ryan Singman, Cleanlab软件工程师

"我们突然有了很多客户,他们希望以非常高的QPS和非常低的延迟使用我们的模型。对我们来说,快速构建一个内部推理平台非常困难。Inferless不仅简化了我们的部署过程,还通过动态批处理增强了我们模型在不同负载下的性能。" —— Kartikeya Bhardwaj, Spoofsense创始人

🌟 Inferless的技术愿景

Inferless正在构建无服务器GPU推理的未来,使公司能够快速且经济高效地运行基于开源框架构建的自定义模型。这是优化高端计算资源的关键一步。

📊 为什么选择无服务器GPU?

| 传统GPU部署 | Inferless无服务器GPU |

|---|---|

| 需要预先配置资源 | 按需自动扩展 |

| 固定月费 | 按秒计费 |

| 冷启动延迟高 | 亚秒级响应 |

| 管理复杂 | 完全托管 |

🛠️ 如何开始使用Inferless?

- 选择你的部署来源:Hugging Face、Git、Docker或CLI

- 设置自动重新部署

- 几分钟内即可上线

🚨 行动号召

还在为模型部署的复杂性而头疼?是时候体验真正的无服务器GPU推理了!

立即访问Inferless官网 开始你的无服务器AI之旅。

"在AI领域,速度就是一切。Inferless让我们能够专注于模型本身,而不是基础设施。" —— 一位满意的用户

📚 延伸阅读

记住:在快速发展的AI世界中,能够快速部署和扩展你的模型可能是成功与失败的区别。Inferless为你提供了这种竞争优势。

产品特性

无需设置、管理或扩展GPU集群。

根据工作负载自动扩展,仅支付实际使用量。

优化即时模型加载,实现亚秒级响应。

SOC-2 Type II认证,定期漏洞扫描。

流量(2025-04)

总访问量

37525

相比上月 -27.94%

平均访问页数

1.68

相比上月 -5.44%

停留时间

36.56

相比上月 -18.57%

跳出率

0.46

相比上月 -0.34%

全球排名

827138

相比上月 +111419

国家排名(IN)

179139

相比上月 +57462

月度流量

流量来源

热门关键词

| 关键词 | 流量 | 搜索量 | 点击成本 |

|---|---|---|---|

| inferless | 607 | 2290 | - |

| qwen 2.5 vs qwq | 221 | 140 | - |

| deep learning precision deepseek | 174 | 30 | - |

| deepseek llm temperature | 112 | 20 | - |

| deep seek model list | 102 | 20 | - |

地域分布

Whois

| 域名 | www.inferless.com |

替代产品

Helpedby AI

AI 数据分析工具

AI助手

AI内容生成器

AI开发工具

AI知识管理

Outerspan

AI 数据分析工具

AI助手

AI电子邮件生成器

AI开发工具

AI 营销计划生成器

AI客户支持工具

Blnk Finance

AI开发工具

Okareo

AI 数据分析工具

AI团队协作软件

AI开发工具

AI监控和报告生成器

HostedMCPPlatform

AI 数据分析工具

AI安全软件

AI开发工具

AI代码生成器

AI监控和报告生成器

AI 应用构建器

BackflipAI

图像处理

3D建模

模型渲染

AI设计生成器

AI开发工具

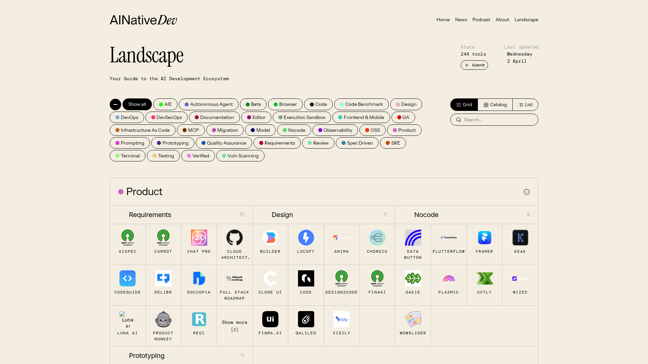

AiNativeDeveloperToolsLandscape

AI开发工具

AI 测试和质量保证

KieAI

AI视频生成器

AI开发工具

AI音乐生成器

在我们精心策划的收藏中发现和对比你的下一个心仪工具

2024 Similarlabs. All rights reserved.

合集

设计师工具集2024 Similarlabs. All rights reserved.